PyTorch LLM 미세조정의 모든 것|효율적인 파이프라인과 성능 최적화 비법

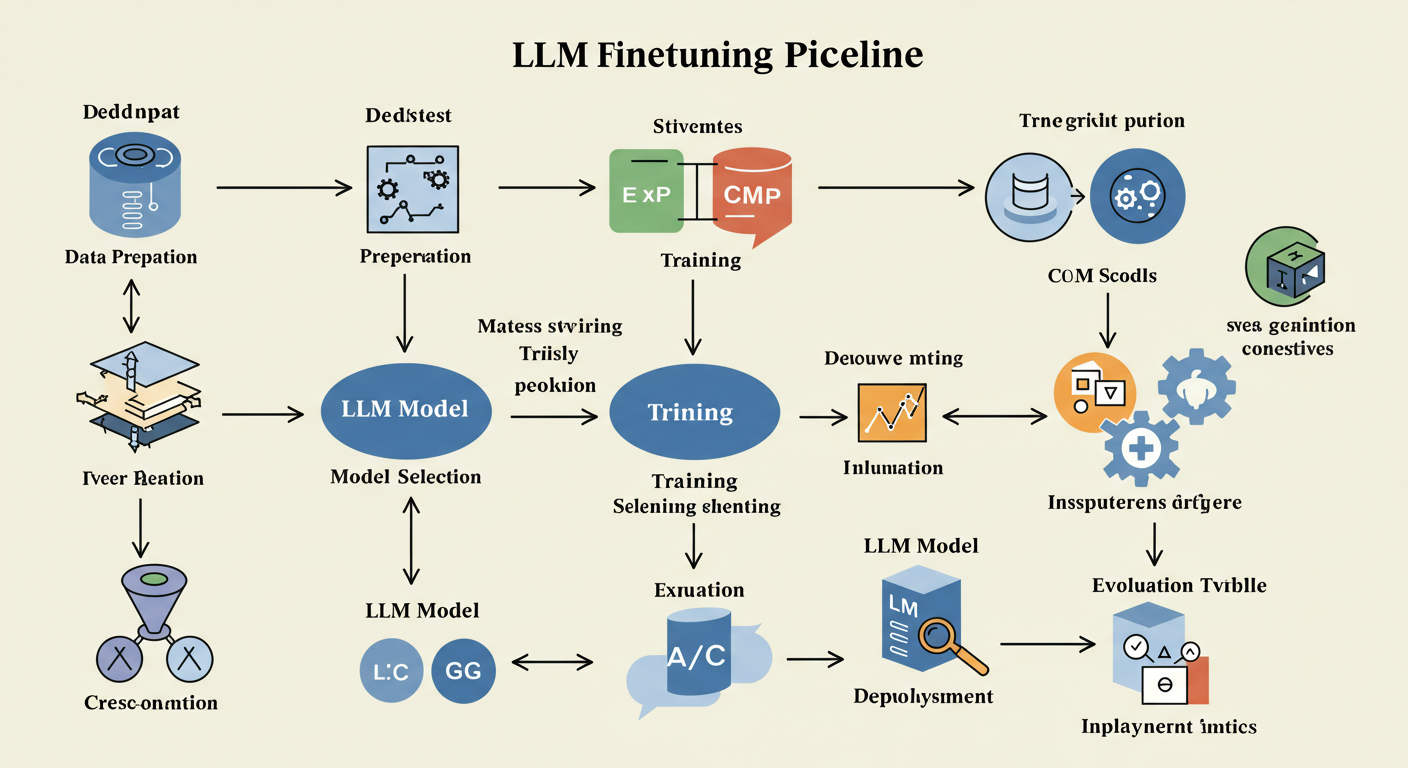

대형 언어모델(LLM) 미세조정은 AI 연구와 산업 현장에서 매우 핵심적인 기술입니다. PyTorch를 활용한 LLM 미세조정의 최신 파이프라인 구성과 성능 최적화 전략을 전문가 수준에서 상세히 다루겠습니다.

목차

PRO TIP:

PyTorch 기반 LLM 미세조정은 데이터, 모델, 하드웨어 자원을 효율적으로 조합하는 것이 성공의 열쇠입니다.

기초 개념부터 최신 기술 동향까지 꼼꼼히 챙겨 보세요!

PyTorch 기반 LLM 미세조정은 데이터, 모델, 하드웨어 자원을 효율적으로 조합하는 것이 성공의 열쇠입니다.

기초 개념부터 최신 기술 동향까지 꼼꼼히 챙겨 보세요!

1. LLM 미세조정 기본 개념 이해

미세조정(Fine-tuning)은 기존 대형 언어모델을 사용자의 특정 태스크에 맞추어 추가 학습시키는 과정입니다. 일반적으로 다음을 포함합니다:

- 사전학습된 대형 모델(예: GPT, LLaMA)을 불러오기

- 맞춤형 데이터셋 준비 및 전처리

- 최소한의 학습률로 추가 학습해 모델을 특화

- 과적합과 과소적합 방지를 위한 기법 적용

2. 데이터 준비와 전처리 전략

고품질 데이터는 미세조정 성공의 기본입니다. 효과적인 데이터 준비 방법은 다음과 같습니다:

- 클린징: 중복 제거, 오탈자 및 비속어 필터링

- 형태소 분석 및 토큰화 전략 선택 (예: SentencePiece, BPE)

- 레이블링 및 데이터셋 구조화

- 데이터 증강 방법으로 다양성 확보

3. 효율적인 미세조정 파이프라인 구성

PyTorch에서 아래 요소들로 파이프라인을 구성하면 효율성을 높일 수 있습니다:

- DataLoader 활용으로 배치 단위 최적 입출력

- Mixed Precision Training 적용해 메모리 절감

- Gradient Checkpointing 도입으로 GPU 메모리 관리

- LoRA (Low-Rank Adaptation) 등 파라미터 효율적 학습 기법 사용

- 학습 상태 저장 및 체크포인트 전략

4. 하이퍼파라미터 튜닝과 최적화 기법

주요 하이퍼파라미터 조절법:

- 학습률(Learning Rate): 1e-5~5e-5 범위 추천, warm-up 스케줄 활용

- 배치 크기: 가능한 최대 GPU 메모리 크기 활용하되, 안정성 유지

- 에폭수(Epochs): 3~10 사이 적절, 과적합 모니터링 진행

- 옵티마이저: AdamW 기반 학습률 스케줄링 결합

- 정규화 및 Dropout 적용, Early Stopping 활용

5. 분산 학습과 메모리 관리 팁

대규모 모델 특성상 다음 기술들이 필수입니다:

- PyTorch DDP (Distributed Data Parallel)를 통한 분산 학습

- Gradient Accumulation으로 소형 GPU에서도 대용량 학습

- Mixed Precision Training 및 AMP 사용 권장

- ZeRO Optimizer 등 메모리 효율화 기법 적용 검토

- 효과적인 GPU 자원 모니터링 및 할당

6. 모델 평가와 추론 최적화

정확도 겸비한 효율적 모델 활용을 위해:

- Validation 셋 기반 정기적 평가로 과적합 방지

- ONNX, TorchScript 등의 최적화 도구 활용

- 양자화(Quantization)과 프루닝(Pruning) 기법 도입으로 추론 속도 개선

- 배포 환경에 맞춘 모델 경량화 및 캐싱 전략

7. 자주 묻는 질문(FAQ)

Q1. 미세조정 시 최소한의 데이터로도 효과가 있나요?

네, LoRA나 PEFT(효율적 파라미터 미세조정) 기법을 활용하면 데이터가 적어도 튜닝 효과를 누릴 수 있습니다.

Q2. GPU 환경이 부족한데 어떻게 해야 하나요?

Gradient Accumulation, Mixed Precision, 클라우드 활용 또는 사전에 모델 경량화 방법을 고려하세요.

Q3. 하이퍼파라미터 튜닝 최적값은 어떻게 찾나요?

Bayesian Optimization, Grid Search 등 자동화 도구 활용과 실험 기록 관리가 필수입니다.

Q4. 추론 최적화 방법으로 추천하는 도구는?

ONNX Runtime, TensorRT, PyTorch Script 등이 대표적이며, 배포 환경에 맞춰 선택합니다.

- PyTorch LLM 미세조정은 파이프라인과 하이퍼파라미터를 효율적으로 설계하는 것이 핵심입니다.

- 데이터 준비, 분산학습, 성능 최적화 기법을 통합 적용해 높은 효율과 성능 달성 가능합니다.

- 최신 기법과 도구를 꾸준히 학습하고 프로젝트에 맞게 유연하게 적용하는 전문성이 필요합니다.

'IT·디지털 가이드 > AI·IT·앱 활용법' 카테고리의 다른 글

| 초보 작가를 위한 디지털 스토리텔링 앱 가이드 글쓰기부터 출간까지 (0) | 2025.09.24 |

|---|---|

| 교육 혁신을 이끄는 메타버스 플랫폼별 특징과 효과적인 수업 도입법 (0) | 2025.09.21 |

| “모든 기기 연동 OK” 스마트홈 통합 IoT 플랫폼 솔루션별 장단점 비교 가이드 (0) | 2025.09.20 |

| 몰입형 교육 환경 만들기|VR/AR 혼합현실 콘텐츠 UX·UI 설계 실무 가이드 (0) | 2025.09.19 |

| LG유플러스 ‘익시오’ 보이스피싱 차단 AI, 글로벌 프라이버시 총회서 주목 (1) | 2025.09.16 |

| 2025 아이폰17 사전예약 시작일 확인! 놓치면 손해보는 혜택은? (1) | 2025.09.14 |

| 자소서 글자수 한눈에! 공백 포함/제외 계산법과 맞춤형 글자수세기 (1) | 2025.09.14 |

| 2025년 최신 AI 개인비서 앱 추천|업무와 일상을 돕는 최고의 선택 (2) | 2025.09.12 |